|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

- # -*- coding: utf-8 -*-

- import requests

- from bs4 import BeautifulSoup

- import traceback

- import re

- def getHTMLText(url, code= 'utf-8'):

- try:

- r = requests.get(url, timeout = 30)

- r.raise_for_status()

- r.encoding = code

- return r.text

- except:

- return ""

-

- def getStockList(lst, stockURL):

-

- html = getHTMLText(stockURL, 'GB2312')

- soup = BeautifulSoup(html, 'html.parser')#解析页面

- a = soup.find_all('a')#找到<a>标签里面的信息

- for i in a :

- try:

- href = i.attrs['href']

- lst.append(re.findall(r"[s][hz]\d{6}", href)[0]) # 找到股票代码

- except:

- continue

- def getStockInfo(lst, stockURL, fpath):

- count = 0

- for stock in lst:

- url = stockURL + stock + ".html"#得到每个股票的链接

- html = getHTMLText(url)

- try:

- if html == "":

- continue

- infoDict = {}

- soup = BeautifulSoup(html, 'html.parser')#对相应的股票页面解析

- stockInfo = soup.find('div', attrs = {'class':'stock-bets'})

-

- name = stockInfo.find_all(attrs = {'class':'bets-name'})[0]#获得股票代码的名称

- infoDict.update({'股票名称':name.text.split()[0]})#加入字典中

-

- keyList = stockInfo.find_all('dt')

- valueList = stockInfo.find_all('dd')

- for i in range(len(keyList)):

- key = keyList[i].text

- val = valueList[i].text

- infoDict[key] = val

-

- with open(fpath, 'a', encoding = 'utf-8') as f:

- f.write(str(infoDict) + '\n')

- count = count + 1

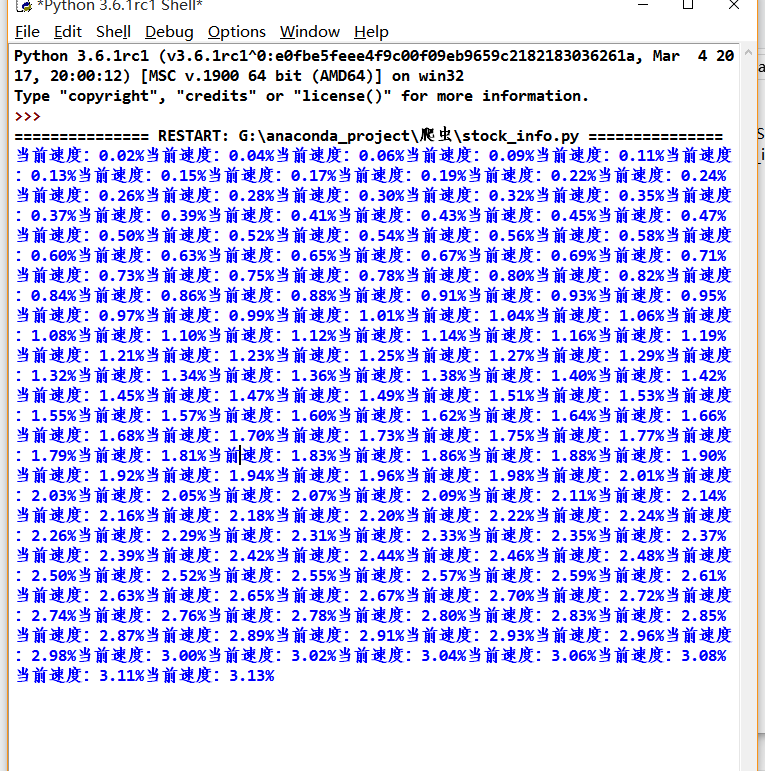

- print("\r当前速度:{:.2f}%".format(count*100/len(lst)), end ="")

- except:

- count = count + 1

- print("\r当前速度:{:.2f}%".format(count*100/len(lst)), end ="")

- continue

-

-

- def main():

- stock_list_url = 'http://quote.eastmoney.com/stocklist.html'

- stock_info_url = 'https://gupiao.baidu.com/stock/'

- output_file = 'G://anaconda_project/爬虫/baiduStockInfo.txt'

- sList = []

- getStockList(sList, stock_list_url)

- getStockInfo(sList, stock_info_url, output_file)

-

- main()

|

-

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)