|

|

马上注册,结交更多好友,享用更多功能^_^

您需要 登录 才可以下载或查看,没有账号?立即注册

x

大家好:

最近因为在用python学网络爬虫,遇到了困惑。无法得到正确的应答。

于是在坛子里找这个问题的解决办法。方法也有很多,有些能成功,有些仍旧无法运行。但刚才找到了一个大神非常简单的修改,再经过自己的试验,得出了最简单的修改。但我不知道为什么要这样改,而通过网络抓取获得的URL却无法得到正确应答?

以下为代码:

- import urllib.parse

-

- import urllib.request

-

- import json

-

- content = input('请输入需要翻译的内容:')

-

- #url = 'http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&smartresult=ugc&sessionFrom=fanyi.logo' #论坛某大神给出的可执行的代码

- url = "http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&sessionFrom=null" #根据可执行的代码进行修改后的代码

- #url = "http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule&sessionFrom=null" #通过网站自行抓取的URL

- data = {}

-

- data['type'] = 'AUTO'

-

- data['i'] = content

-

- data['doctype'] = 'json'

-

- #data['xmlVersion'] = '1.8'

- data['version'] = '1.8'

-

- data['keyfrom'] = 'fanyi.web'

-

- data['ue'] = 'UTF-8'

-

- #data['action'] = 'FY_BY_CLICK_BUTTON'

-

- data['typoResult'] = 'true'

-

- data = urllib.parse.urlencode(data).encode('utf-8')

-

- response = urllib.request.urlopen(url,data)

-

- html = response.read().decode('utf-8')

-

- target = json.loads(html)

-

- print('翻译结果:%s' % (target['translateResult'][0][0]['tgt']))

-

顺便贴上自己抓取的信息。

|

-

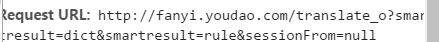

抓取的URL

-

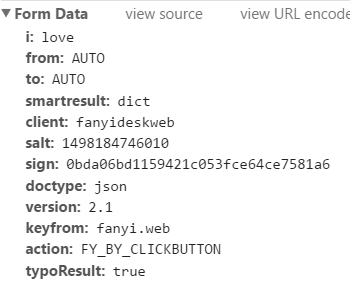

form data

|

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)

( 粤ICP备18085999号-1 | 粤公网安备 44051102000585号)